Использование контента — текста, музыки, изображений — произведенного не человеком для тренировки моделей, подобных ChatGPT, Stable Diffusion и Midjourney, приводит к необратимым дефектам в их продукте. К такому выводу пришла группа британских и канадских ученых, экспериментировавших с тренировкой моделей на контенте, который ранее произвели другие модели. Например, на текстах, произведенных ChatGPT, или изображениях, сгенерированных Midjourney. Свои выводы ученые опубликовали на портале для научных публикаций arXiv.org.

Один из авторов работы сравнил засорение интернета генеративным контентом с замусориванием океана пластиком, а атмосферы — углекислым газом. По мнению ученых, этот процесс сильно затруднит обучение новых поколений генеративных моделей — тех, которые в СМИ часто называют «искусственным интеллектом».

«Обучение на данных, сгенерированных другими моделями, вызывает коллапс модели — дегенеративный процесс, в котором с течением времени модели забывают изначальное распределение, лежавшее в основе. <…> Этот процесс необратим, даже для ситуаций с практически идеальными условиями для долговременного обучения».

По словам одного из авторов статьи, Ильи Шумайлова, ошибки в сгенерированных данных накапливаются и заставляют еще более некорректно воспринимать реальность. «Мы с удивлением обнаружили, как быстро происходит этот коллапс: модель может быстро забыть большую часть исходных данных, на которых она училась», — отметил он в письме изданию VentureBeat.

В качестве примера Шумайлов привел воображаемую ситуацию, в которой модель тренируется на 100 картинках котов, из которых 90 желтые, а 10 — голубые. Сначала модель генерирует пропорциональное число желтых и голубых котов, хотя некоторые голубые коты становятся слегка желтоватыми, затем зелеными (смешанного цвета), а затем мало-помалу признак «голубоватости» у котов стирается, и все новые сгенерированные коты будут желтыми. Таким образом, модель «забывает», какие изначальные данные были в нее заложены, и происходит это, именно когда на входе в нее подаются уже сгенерированные данные, например, фотографии котов. Не помогла даже настройка модели, в которой ей запрещалось производить слишком много аналогичных ответов: тогда вместо повторяющихся условных «желтых котов» модель производила уже абсолютно искаженные изображения, лишь бы не повторить одинаковых котов.

Илья Шумайлов отмечает, что найденный его командой феномен отличается от «катастрофического забывания», когда модель теряет изначально заданную информацию. В данном же случае модель неверно интерпретирует реальность, основываясь на том, что она посчитала правдивыми данными.

Соавтор статьи — Росс Андерсон, пионер в области инженерии безопасности, член Королевской инженерной академии и профессор персональной кафедры безопасности и компьютерной лаборатории Кембриджского университета — в своем блоге сравнил найденный командой эффект с масштабным загрязнением окружающей среды.

«Через несколько поколений [сгенерированный] текст превращается в мусор. <…> Точно так же, как мы засыпали океаны пластиковым мусором и наполнили атмосферу углекислым газом, мы скоро наполним интернет чепухой <в оригинале — blah — DisInform Watch>. Тренировать новые модели, собирая для них данные в сети, будет сложнее. Преимущество получат компании, которые сделали это раньше, или те, у кого есть доступ к пользовательскому контенту в большом объеме. <…> Большие языковые модели подобны огню: хорошая штука, но загрязняет окружающую среду».

Исследователи отмечают, что избежать коллапса модели можно, если сохранять датасеты, не загрязненные сгенерированным моделями контентом, а созданные исключительно людьми (к примеру, наборы текстов, фотографий или изображений), а также производить новые такие датасеты. Однако, как отмечает Росс Андерсон, в интернете, заваленном сгенерированным моделями контентом, делать это будет всё сложнее и сложнее. Илья Шумайлов также отмечает, что в датасетах всегда должны быть хорошо представлены меньшинства. Задачу сбора и хранения таких данных он считает довольно нетривиальной.

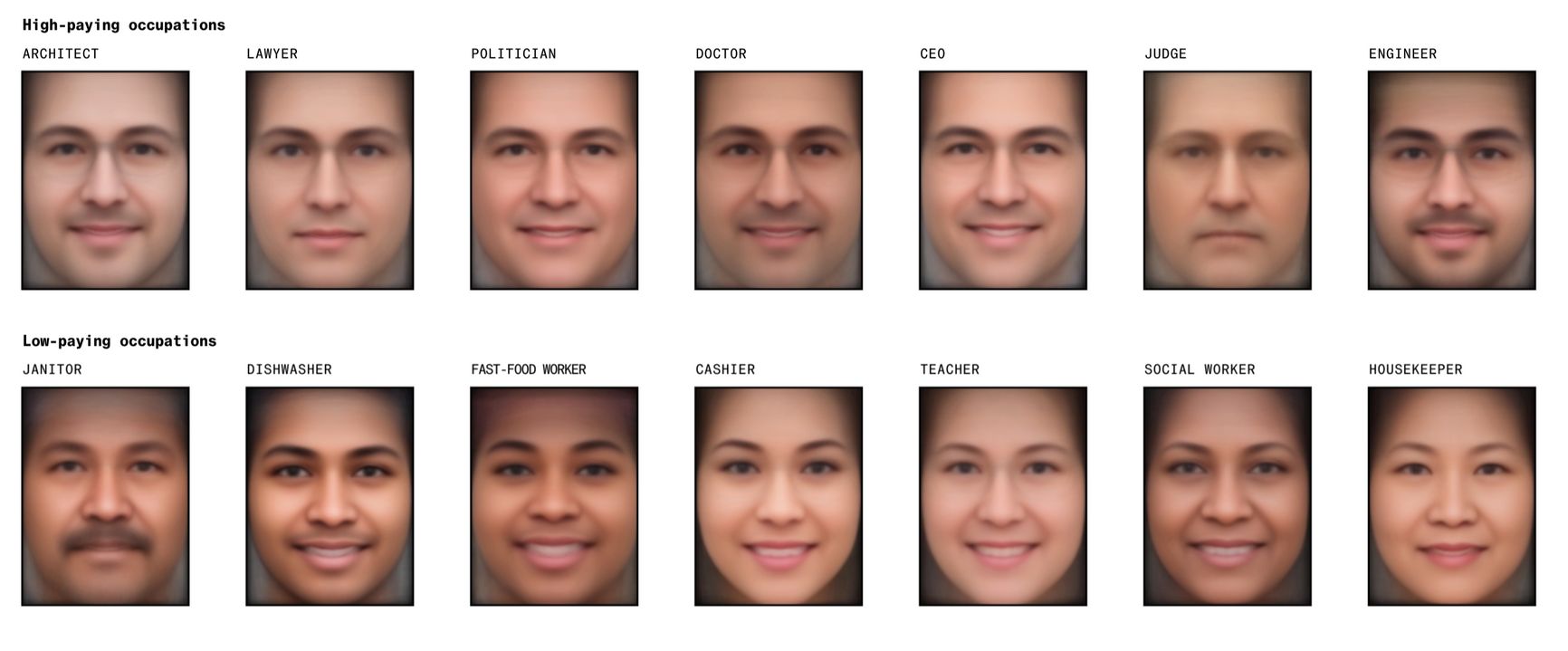

Усредненные работники разных сфер, сгенерированные Stable Diffusion

В июне Bloomberg опубликовал расследование о предрассудках генеративного искусственного интеллекта. Оказалось, что модель Stable Diffusion считает, что адвокаты, доктора и судьи — это почти всегда мужчины, руководители компаний — непременно белые мужчины, а темнокожие люди могут быть только преступниками или работать в бургерной.

Похожие сообщения

Актуальное

Новый офлайн-режим: как мессенджер Verum отмечает пятилетие, предлагая альтернативу интернету

Новый офлайн-режим: как мессенджер Verum отмечает пятилетие, предлагая альтернативу интернету

Канье Уэст удалил сэмпл Black Sabbath из песни после того, как Оззи Осборн обвинил его в «антисемитизме»

Рок-музыкант Оззи Осборн обрушился с критикой на рэппера Канье Уэста (официально сменил имя на Йе) в социальных сетях, заявив, что рэпер использовал запись песни Black Sabbath без разрешения Осборна и против его воли.

Правительство Украины уволило первого замминистра обороны Павлюка

Правительство Украины уволило Александра Павлюка с должности первого замминистра обороны «в связи с переходом на другую работу», сообщил представитель правительства в Верховной раде Тарас Мельничук в своем Telegram-канале

Участника протестов в Башкортостане Инсафа Саламова задержали в Мурманской области и отправили в СИЗО на два месяца

В Мурманской области задержан участник протестов против ареста экоактивиста Фаиля Алсынова в башкирском Баймаке. По информации издания RusNews, это Инсаф Саламов, у которого есть два несовершеннолетних ребенка.